Mit der zunehmenden Reife von ML/KI und dem Einsatz hochentwickelter Modelle in neuen (und kritischen) Branchen ergeben sich neue Herausforderungen. Eine der häufigsten ist die Wahrnehmung, dass sich diese Modelle wie Blackboxen verhalten - d. h. es ist schwierig zu verstehen, wie sie funktionieren und welche Überlegungen hinter ihren Vorhersagen stehen. Dies geht einher mit zunehmenden Bemühungen um die Beseitigung von Verzerrungen (d. h. die Entdeckung, dass das Modell bei der Vorhersage diskriminierende Merkmale verwendet). Beides führt dazu, dass das Misstrauen gegenüber diesen ML-/KI-Systemen zunimmt. Der Bereich, der sich mit diesen Problemen befasst, wird erklärbare KI oder kurz xAI genannt. In diesem Blogbeitrag werde ich Ihnen die Beweggründe für diesen Bereich erläutern.

Worte der Warnung / Hype

Bevor wir beginnen, möchte ich ein paar Worte der Vorsicht aussprechen. Während die "Blackbox" des maschinellen Lernens kein neues Thema ist und schon seit der Entwicklung der ersten Algorithmen ein Problem darstellt, ist die neue Welle von Erklärungsmethoden eine relativ junge Entwicklung. Aufgrund dieser Tatsache sind viele der Methoden in diesem Bereich noch nicht gründlich in verschiedenen Umgebungen getestet worden, und es gibt auch kaum wissenschaftliche Arbeiten zu diesem Thema. Aus diesem Grund sollten Sie bei der Anwendung dieser Methoden in kritischen Produktionssystemen sehr vorsichtig sein und die Methoden gründlich studieren, bevor Sie sie blindlings anwenden.

Leider ist auch xAI in den Hype und den Buzzword-Sturm verwickelt, dem der Bereich der KI allgemein zum Opfer fällt. Dieser Hype kann sowohl den Wert als auch die Gefahren des Einsatzes dieser Methoden verschleiern und die Auswahl der besten Methode erschweren.

Was ist xAI?

Lassen Sie uns in einem ersten Schritt xAI definieren. Auch wenn es in diesem Bereich Unterschiede zwischen den beiden Begriffen gibt, werden wir der Einfachheit halber die Begriffe Interpretierbarkeit und Erklärbarkeit synonym verwenden. Die beste Definition, die ich gefunden habe, ist diese:

Interpretierbarkeit* ist der Grad, in dem ein Mensch die Ursache einer Ursache einer Entscheidung verstehen kann (Miller, 2017).

Wir können uns auf zwei spezifische Wörter in dieser Definition konzentrieren - Mensch und Entscheidung. Dies zeigt, dass der wichtigste Gedanke dieses Bereichs darin besteht, Menschen zu helfen, maschinelle Lernsysteme zu verstehen.

Warum brauchen wir sie?

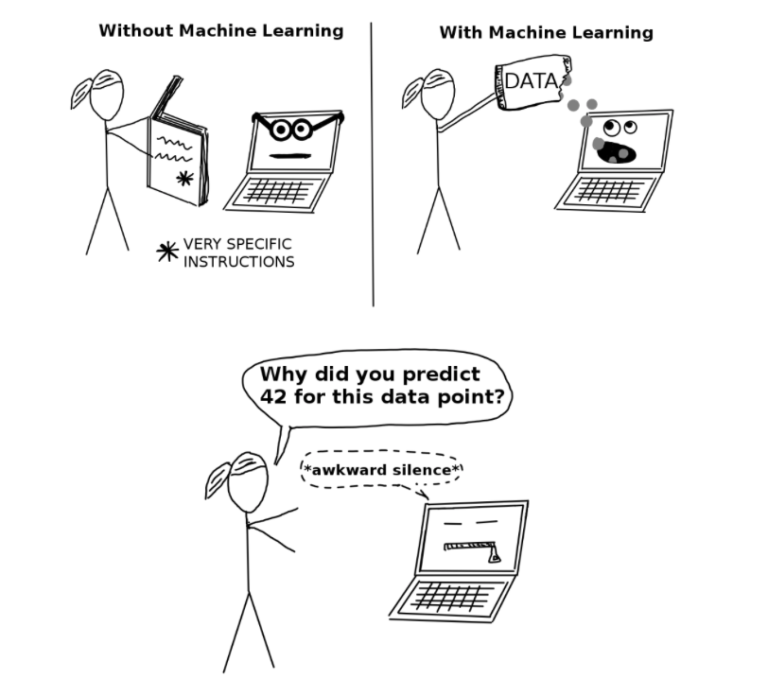

In der Computerwelt vor dem Aufkommen des maschinellen Lernens wurden die von Maschinen getroffenen Entscheidungen in einer sehr strengen Weise ausgeführt. Dadurch waren die Ergebnisse solcher Programme viel leichter zu verstehen, da man nur den Quellcode verstehen musste. Heutzutage fällt es jedoch selbst erfahrenen Datenwissenschaftlern schwer, die Gründe für die Vorhersagen ihrer Modelle zu erklären, und der Prozess scheint wie Magie - man gibt die Daten ein, fügt ein Ziel für die Vorhersage (Entscheidung) hinzu und erhält das Ergebnis - ohne dass man dazwischen einen Hinweis auf den Entscheidungsprozess erhält. Dieses Problem wird in der nachstehenden Zeichnung veranschaulicht:

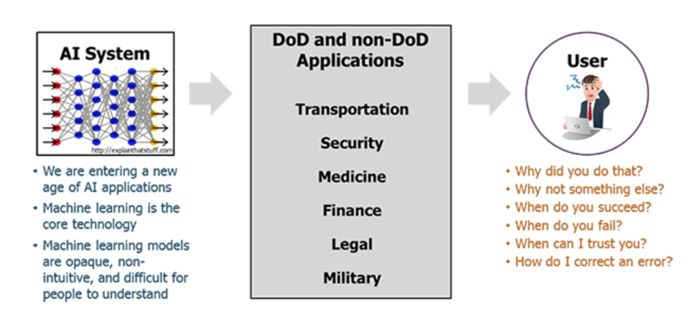

Ein weiterer wichtiger Motivationsfaktor für die Entwicklung des xAI-Bereichs ist die zunehmende Reife von ML-Systemen für die Produktion in kritischen Branchen. Während um 2009 die meisten maschinellen Lernsysteme in den Produkten von Tech-First-Unternehmen (z. B. Google, Youtube) eingesetzt wurden, bei denen eine falsche Vorhersage dazu führen würde, dass dem Anwendungsnutzer eine falsche Empfehlung angezeigt wird, werden diese Algorithmen heute in Bereichen wie dem Militär, dem Gesundheitswesen und dem Finanzwesen eingesetzt. Die Ergebnisse der Vorhersagen in diesen neuen KI-Branchen können weitreichende und dramatische Folgen für das Leben vieler Menschen haben - daher müssen wir unbedingt wissen, wie diese Systeme ihre Entscheidungen treffen.

DoD steht für Department of Defense (Verteidigungsministerium).

Im Zusammenhang mit diesem Thema gibt es auch Gesetze wie die Datenschutzgrundverordnung und das "Recht auf Erklärung". Ein Datenwissenschaftler, der ein Modell des maschinellen Lernens in der Produktion einsetzt, kann rechtlich verpflichtet sein, zu erklären, wie es Entscheidungen trifft, wenn diese Entscheidungen große Auswirkungen auf Menschen haben können.

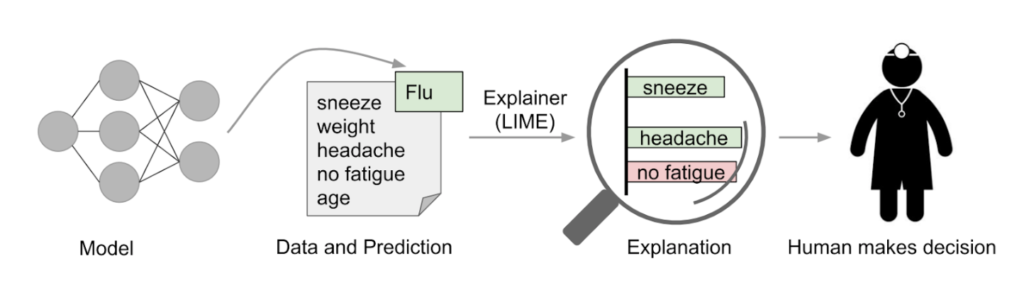

xAi kann auch für die Endnutzer von Anwendungen von Vorteil sein. Mit Systemen wie diesem werden sie mehr Vertrauen haben. Nehmen wir eine KI-gestützte Anwendung im Gesundheitswesen. In diesem Fall kommt es häufig vor, dass das technische Team den Fachexperten (oder in diesem Fall den Anwendungsnutzern) über die Modellleistung berichtet. Die Ingenieure berichten, dass das Modell eine Vorhersagegenauigkeit von 95 % erreicht, wenn es darum geht, ob ein Patient eine bestimmte Krankheit hat oder nicht. In den meisten Fällen würden die Fachleute des Gesundheitswesens ungläubig auf solche Ergebnisse reagieren und sagen, dass es einfach nicht möglich ist, so genau zu sein. Wenn wir in diesem Fall eine Methode wie Local Interpretable Model-agnostic Explanations (LIME) verwenden, um zu erklären, warum ein bestimmter Patient als nicht krank eingestuft wird, sollte das Vertrauen in das System verbessert werden. Die Ärzte sollten in der Lage sein zu erkennen, dass das Modell eine sehr ähnliche Logik hat wie sie selbst, wenn sie eine Diagnose stellen. Dieses Szenario ist unten dargestellt, wo das Modell zeigt, dass der Patient, auch wenn er einige Symptome wie Niesen und Kopfschmerzen hat, nicht krank ist, weil er keine Müdigkeit zeigt.

Wir haben nun die Grundlagen von xAI und ihre Möglichkeiten besprochen. In den nächsten Beiträgen werden wir darüber berichten, welche Methoden und zugehörigen Software-Tools für xAI verfügbar sind.